Liste de partage de Grorico

Liste de partage de Grorico

Dans le même esprit que les différentes séries par Christoffer Relander et Dan Mountford, coup de cœur pour cet artiste japonais Miki Takahashi qui nous dévoile une série de portraits en double exposition visuellement magnifiques. Appelée « Two Sides of Personality », cette série de clichés est à découvrir dans la suite.

L’un des grands intérêts de Twitter réside dans son API relativement ouverte, c’est-à-dire la possibilité offerte aux développeurs de construire des applications basées sur les données délivrées par le site de micro-blogging. C’est ce qui donne lieu à la kyrielle d’applications et d’outils destinés à améliorer l’utilisation de Twitter. Clients,...

Article publié sur le Blog du Modérateur : L’avenir s’assombrit pour l’écosystème Twitter Suivez également l'actualité du blog sur Twitter et Facebook

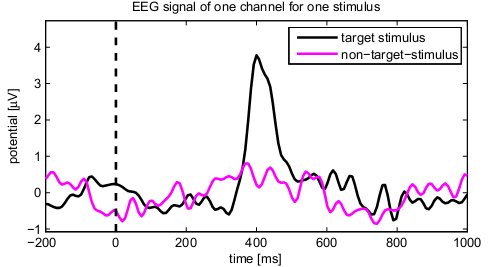

Le saviez-vous ? Il est maintenant possible de hacker le cerveau humain. C'est ce qu'ont expliqué des chercheurs lors de la conférence Usenix sur la sécurité qui s'est déroulé du 8 au 10 août dernier dans l'État de Washington.

Voici comment ça fonctionne...

Grâce à une EEG (Électro-encéphalographie, c'est-à-dire des capteurs posés sur la tête), on est capable de mesurer depuis longtemps l'activité du cerveau. En couplant ces mesures avec un logiciel de leur cru, il devient possible de "trouver" des informations personnelles à l'intérieur du crâne d'une personne comme son adresse, le code de sa carte bleue, da date de naissance...etc.

Cela fonctionne un peu comme un bruteforce de mot de passe. Lorsque la personne soumise au test voit défiler devant ses yeux quelque chose qu’elle reconnait comme un chiffre, un visage ou un objet, son cerveau émet une onde cérébrale baptisée la réponse P300. Cette réponse intervient lorsque quelque chose de familier est reconnu. Ainsi, il devient possible de débusquer des informations bien cachées dans le cerveau et cela, avec un taux de succès allant jusqu'à 40% (on en est qu'au début...).

C'est un peu le détecteur de mensonges ultime et je parie que lorsque la technique sera fiable, la police et les voyants-medium-marabouts seront ravis de s'en servir sur leurs victimes ^^.

Passionnant en tout cas. (et flippant)

Par exemple, pour accéder au site http://dppmfxaacucguzpc.onion/ ajoutez simplement le ".to": http://dppmfxaacucguzpc.onion.to/

/!\ ATTENTION: Vous n'êtes bien entendu pas anonyme en utilisant ce service.

“Ainsi donc, nous souhaitons étendre le nombre et la diversité des données réutilisables. Mais pourquoi, en fait ? Pourquoi, en particulier, les entreprises contribueraient-elles à l’Open Data?” C’est avec cette question que Daniel Kaplan, délégué général de la Fondation internet nouvelle génération, entamait son intervention de synthèse de la session sur l’Open Data appliquée au monde de l’entreprise pendant la semaine européenne de la réutilisation des données publiques qui se tenait à Nantes du 21 au 26 mai 2012. “Certes, beaucoup d’entreprises veulent agir en bons citoyens, mais cette motivation ne peut pas leur suffire…”

Nous n’avons jamais pris les données au sérieux

“Nous n’avons jamais pris les données au sérieux et aujourd’hui, elles se vengent”, estime Daniel Kaplan.

Les données sont pour la plupart des constructions ad hoc visant à remplir les variables des programmes, explique-t-il. Elles sont strictement définies en fonction des objectifs du programme. Comme les programmes sont souvent conçus comme s’ils étaient uniques au monde, leurs données se retrouvent souvent dupliquées, sous des formes diverses, un peu partout dans les systèmes d’information des organisations. Et l’on ne se préoccupe guère d’en limiter le nombre : “pourquoi chercher à réduire l’effort nécessaire à la collecte et au traitement des données s’il n’existe pas d’autre programme que le mien ?” Plus souvent qu’on ne le pense, elles sont aussi très mal entretenues et ont tendance à survivre à leur pertinence et à leur utilité, conservées ad vitam ad aeternam…

Image : Daniel Kaplan sur la scène de l’Open Data Week, photographié par Mathieu Drouet pour la Fing.

Mais à l’heure de l’innovation ouverte, la plupart des chaînes de valeur et des modèles de services associent de multiples organisations. Le web ne relie plus seulement des pages, mais des services, des applications et des données. Du côté des utilisateurs, les “entrepôts de données personnels” et la “gestion de la relation commerçant” (VRM) modifient également la dynamique d’interaction : les sociétés ne sont plus les seules à utiliser des systèmes d’informations, leurs clients disposent également des leurs.

Ce Nouveau Monde relie d’une manière souple les organisations, les projets, les services et les applications autour de données et de services (au sens de “web services”). Pour fonctionner, il a besoin de données fiables, cohérentes, précisément décrites, liées, accessibles (dans des conditions claires) et peu coûteuses. Les systèmes sont appelés à collaborer de plus en plus entre eux et c’est là que se nicheront à l’avenir le progrès, la croissance, les échanges, estime Daniel Kaplan.

L’ouverture banalisée

“Par conséquent, faire en sorte que la plupart des données soient en quelque sorte “ouvertes” sera bientôt une décision ordinaire pour les entreprises.”

A l’avenir, les systèmes d’informations sépareront vraiment les données des process – ce que les méthodes de conception proclament depuis des années, avec des résultats décevants. Les données existeront dans des serveurs et des entrepôts, avec des mécanismes et règles d’accès lisibles et claires, comme c’est déjà le cas avec les interfaces de programmation (API). “L’ouverture des données ne relèvera pas de décisions binaires (ouvrir ou fermer), mais plutôt d’un réglage fin des degrés d’ouverture et d’autorisations d’accès : à d’autres entités de l’organisation ? A ses partenaires habituels ? A son “écosystème” étendu ? A tout le monde, de manière gratuite ou payante ?…”

A l’avenir, les entreprises devront constamment accéder à des données externes, en particulier aux entrepôts de données de leurs clients, fournisseurs et utilisateurs. Pour mériter l’accès, il faudra qu’il soit réciproque et que l’usage des données respecte les règles définies par leur source, comme l’expliquait très bien Alan Mitchell : “l’enjeu est de responsabiliser l’entreprise sur les données qui lui sont confiées, selon les conditions définies par l’utilisateur”.

Dans ce contexte, la question de la transparence ne sera pas la motivation principale à l’ouverture des données, estime Daniel Kaplan. La responsabilité sociale de l’entreprise fera certes partie intégrante des motivations, mais elle jouera comme d’habitude un rôle secondaire. “Le partage des données sera la façon normale de travailler. Parce que l’alternative serait tout simplement trop stupide et inefficace.”

Les enjeux des données d’entreprise ouvertes

La vraie question n’est donc pas de savoir si les entreprises ouvriront leurs données. Elles les ouvriront. Ni de savoir si elles vont vendre leurs données. Elles ne les vendront pas la plupart du temps, parce que “l’information veut être libre et gratuite” comme le clamait Steward Brand dès 1987 et parce que “leur valeur commerciale réside dans ses usages et non pas dans leur existence brute”.

Il ne s’agit donc pas de savoir si l’on va ouvrir les données, mais comment et à quel niveau. C’est là que se situent les enjeux insiste Daniel Kaplan en nous invitant à nous concentrer sur deux d’entre eux : la minimisation et l’autonomisation.

Minimisation

L’Open Data est souvent associé aux “Big Data”, une tendance récente de l’informatique qui se propose d’explorer un Nouveau Monde de connaissances, des corrélations inédites et de prédictibilité.

Le marketing constitue le principal marché des Big Data. Il s’agit d’accumuler et de traiter un maximum d’information pour deviner ce que vont acheter les utilisateurs et à quel moment. Or dans ce domaine, la protection des données personnelle a donné naissance à une autre expression en vogue, la data minimization. Pour protéger la vie privée des consommateurs “dès la conception” des systèmes informatiques (privacy by design), on cherchera à collecter et à exploiter aussi peu d’informations personnelles que possible, et pendant la durée la plus courte possible.

Certes, la plupart des données “ouvertes” ne sont pas nominatives. Mais il y a nombre d’exemples où l’agrégation de données disparates et anonymes fournit d’assez bonnes informations sur les situations et comportements individuels. Dans le monde des Big Data, la plupart des données peuvent devenir personnelles.

“En ce sens, la minimisation ne revêt pas seulement une signification éthique. Elle a également un sens économique et commercial : moins d’informations inutiles à gérer, moins de risques d’erreur, plus de confiance. Moins vous cherchez à en savoir sur vos clients, plus il vous est facile de répondre à leur demande de transparence.”

“Mais il y a encore une autre raison pour minimiser les données, autrement dit, de réfléchir sérieusement à celles dont vous avez besoin pour accomplir une tâche donnée. Les données sont des constructions. Elles sont créées par des personnes, des machines et des interfaces particulières, dans des buts, des contextes et des faisceaux de contraintes spécifiques. En les réutilisant sans autre forme de procès, dans d’autres contextes, nous risquons de nous faire des illusions sur le caractère mesurable et intelligible de la réalité.” Le risque est par exemple d’automatiser trop de décisions ou de relations, comme l’explique très bien Helen Nissenbaum.

“La tension entre les données ouvertes et la minimisation est productive. Elle nous aide à penser. Elle ne doit pas nous empêcher de partager des données, mais nous aider à garder à l’esprit que ce n’est pas parce que les données deviennent toujours plus ouvertes et réutilisables que nous devrions tout transformer en données.”

Autonomisation

“A qui l’ouverture confère-t-il du pouvoir, des nouvelles capacités ?”, interroge Daniel Kaplan. “Nous aimerions croire qu’il s’agit de tout le monde. Mais ça ne se passera pas comme ça, sauf si nous le voulons vraiment.”

Initialement, ouvrir quelque chose sert souvent à donner du pouvoir à ceux qui en ont déjà (empower the empowered) : ceux qui disposent des moyens et du savoir-faire, ceux qui savaient que cela allait se passer et qui ont planifié en conséquence… A titre d’exemple, plusieurs études sur la libération des données de la propriété foncière et le prix des logements ont montré qu’elles ont d’abord été utilisées par des professionnels, que ce soit pour expulser les pauvres des terres qu’ils occupaient de manière informelle au Bangladesh, ou pour repérer des New-Yorkais qui ne payaient pas les loyers maximaux qui pouvaient être espérés dans leurs quartiers.

L’ouverture permet ensuite à de nouveaux acteurs dominants d’émerger, parce qu’ils savent mieux que d’autres exploiter cette ressource nouvelle.

“Si nous ne pouvions espérer que cela de l’ouverture des données, alors il faudrait en remettre en cause son existence même”, insiste Daniel Kaplan. “La raison d’être de l’Open Data est de générer autant d’interprétations et d’usages féconds que possible (ce qui signifie qu’il en faut aussi beaucoup de stériles) ; de faire des gens des contributeurs à la production des données elles-mêmes, y compris celles des entreprises ; de créer un terreau fertile pour toutes sortes d’interactions, de discussions sur des questions communes…”

“Mais si les données, mêmes ouvertes, restent inaccessibles et mystérieuses à la plupart des gens, nous ne bénéficierons pas de l’innovation, de la contribution, de la proximité, de la qualité du débat que nous attendons de cette libération des données”, insiste Daniel Kaplan. Cela signifie que nous avons besoin d’être actifs dans la création de plateformes, d’outils, de lieux dans lesquels l’existence et la signification des données ouvertes deviennent visibles et qui aident les gens à les utiliser. Nous devons créer une culture des données entre tous les types d’acteurs, entre tous les partenaires de la chaîne de valeur : que ce soit les organismes publics, les PME, les médias, les ONG, les groupes de consommateurs… Nous avons besoin de médiateurs et d’activistes des données à l’intérieur comme à l’extérieur de nos organisations, comme nous y invite le concept – émergent – d’Info Labs. “L’innovation ouverte a besoin d’innovateurs et par conséquent, d’un écosystème qui permette aux acteurs, du plus puissant au plus petit, de se rencontrer. L’Open Data a exactement les mêmes besoins parce qu’il est de même nature.”

Hubert Guillaud

Disclamer : Daniel Kaplan est délégué général de la Fing, éditeur d’InternetActu.net.

Retrouvez notre dossier réalisé à l’occasion de la semaine européenne de l’Open Data :

- Open Data (1/4) : Où en est-on ?

- Open Data (2/4) : Animer, animer et encore animer

- Open Data (3/4) : L’enjeu de la coproduction

- Open Data (4/4) : Le monde de l’entreprise face au défi de l’ouverture…

- Supplément : Vers un Nouveau Monde de données

- Supplément : Les enjeux de l’extension de l’Open Data au monde de l’entreprise

La messe semble dite. La connaissance devrait désormais progresser par la multiplication des données et leur traitement statistique. Au point que certains – et non des moindres – déclarent désormais dépassée la bonne vieille méthode scientifique. Les Big Data vont nous permettre de nous passer de théories, semble-t-il. Mais les statistiques sont loin d’être un outil facilement maniable, et les pièges méthodologiques ne manquent pas.

Des vérités que les adeptes contemporains du Quantified self risquent d’apprendre à leur dépends s’ils décident se fier un peu trop facilement aux diverses études concernant la santé. Ainsi ces dernières semaines, la presse internationale (y compris française, c’est dire !) a donné un large écho à plusieurs études : la première affirmait que le chocolat pouvait faire maigrir, tandis que la viande rouge abrégeait notre durée de vie. Plus récemment encore, on a appris que le café augmentait la longévité. Gary Taubes, auteur de plusieurs ouvrages sur les sciences, dont Good calories, bad calories (un livre plus “vulgarisateur”, FAT a même été traduit en français) s’est penché dans Discover Magazine sur la valeur de ce genre de travaux.

Les biais multiples nuisent à l’observation

L’auteur remarque que ces études peuvent être considérées comme appartenant à une branche nommée “épidémiologie observationnelle” qu’il considère “plus proche de la pseudoscience que de la science réelle”.

Se reposant sur les travaux du philosophe et épistémologiste Karl Popper, Taubes rappelle que “la méthode scientifique consiste à faire des conjectures audacieuses puis à trouver des moyens exigeants et ingénieux pour les réfuter.”

L’observation selon laquelle la viande rouge pourrait réduire la durée de vie est une de ces “conjectures audacieuses”, explique Taubes.

“Tout le monde peut faire des conjectures audacieuses, poursuit-il. Par exemple, “les extraterrestres causent des maladies cardiaques”… La difficulté, c’est de mettre au point les moyens audacieux et sérieux pour les réfuter”.

Comment fonctionnent ces études basées sur l’observation ? On prend des milliers de sujets, on leur fait remplir un questionnaire, et on les suit sur plusieurs années.

L’une des premières causes d’erreurs dans ce genre de travaux est la confusion des causes. Ainsi, si l’on prend une échelle allant des végétariens purs et durs aux consommateurs quasi exclusifs de viande rouge, on observe que les autres facteurs de mortalité augmentent dans la même proportion que les habitudes carnivores. Autrement dit, plus on consomme de viande, plus on fume, on boit, on est sédentaire, etc. Difficile dans ces conditions d’isoler la viande rouge comme le facteur limitant la longévité.

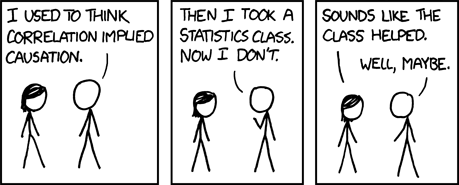

Image : un petit strip de Randall Munroe : “Je pensais que la corrélation impliquait la causalité. J’ai pris un cours de statistiques et maintenant je ne le pense plus. Visiblement le cours a aidé. Euh… Peut-être”.

Taubes cite un autre biais souvent ignoré : celui de “conformité”. Il l’illustre par l’exemple suivant. Une expérience effectuée sur un médicament pour le coeur, réalisée avec toutes les précautions nécessaires (autrement dit avec un groupe témoin utilisant des placebos) s’était révélée un échec, et les chercheurs en avaient déduit l’inefficacité du produit en question. Pourtant, ils n’en sont pas restés là et se sont demandé qui, parmi les sujets, avait réellement suivi la prescription médicale. Ils ont alors découvert, à leur grande satisfaction, que les patients qui avaient suivi scrupuleusement le protocole avaient en effet bénéficié d’une longévité accrue par rapport aux autres, plus dilettantes. Cela aurait suffi à montrer que finalement le médicament était efficace, poursuit Taubes, mais les chercheurs ne se sont pas arrêtés là et ont découvert que les consommateurs “réguliers” du placebo voyaient eux aussi leur santé s’améliorer dans de fortes proportions ! Taubes attribue cela au fait que les usagers du placebo, comme les autres se montraient plus prompts à suivre les recommandations de leur médecin. Un paramètre difficile à évaluer lorsqu’on effectue de simples observations.

Une autre source d’erreur possible est liée au pourcentage constaté. Les études sur la viande rouge montrent que la mortalité accrue est de l’ordre de 20 %. Un tel chiffre est quasiment insignifiant. Surtout si on le compare avec le tabac : un fumeur a 20 fois plus de chances qu’un non-fumeur d’avoir un cancer du poumon. Autrement dit, le risque impliqué par la viande rouge est 100 fois plus petit que celui constaté avec le tabac. Une si petite association n’est guère significative, affirme Taubes. Alors que l’observation simple suffit à établir la dangerosité du tabac, à cause de l’importance de la mortalité qui y est associée, ce ne peut être le cas pour la viande rouge.

La troisième possibilité d’erreur n’est autre que la confusion de la cause et de la conséquence. Le chocolat aide-t-il vraiment à maigrir ? Peut-être, au lieu de penser, argue Taubes, que les mangeurs de chocolat ont tendance à être plus maigres, devrait-on considérer que les gens maigres mangent plus facilement du chocolat, parce qu’ils savent qu’ils peuvent se le permettre. Les gens plus gros, eux, n’ignorent pas que le produit aura pour eux des conséquences négatives. Et je peux confirmer le soupçon de Taubes sur ce point. Je connais quelqu’un qui se nourrit essentiellement de Granola et qui ne prend jamais un gramme. Un régime que je ne pourrai certainement jamais me permettre.

Pour Taubes, ces expériences fondées sur l’observation pure ne constituent en rien de la vraie science, qui se base non sur des observations nues, mais sur des expériences.

“Nous disposons au moins de deux moyens raisonnables d’expliquer l’association minuscule entre la consommation de viande et la mortalité accrue. La première est qu’elle est causée par la viande elle-même. L’autre par les comportements qui sont associés à la consommation de viande. Donc, la solution serait de faire une expérience pour voir qui a raison. Commencez avec une cohorte de sujets et affectez-les au hasard à un groupe qui mangera, soit un régime riche en viande rouge et en viande préparée, soit à un régime pauvre en viande – un régime essentiellement végétarien. En distribuant les sujets au hasard dans chacune de ces deux interventions, nous pouvons nous débarrasser des facteurs comportementaux (socio-économiques, éducatifs, etc.) qui pourraient s’associer avec le choix personnel d’être végétarien ou quasi végétarien ou au contraire mangeur de viande.”

A noter que pour Taubes de telles expériences ont été faites. Et de citer une étude de l’université de Stanford, basée sur ces principes, et qui, contrairement à l’opinion commune, a trouvé que les régimes riches en protéines et pauvres en hydrates de carbone se révélaient préférables non seulement pour la perte de poids, mais aussi pour la santé. A noter toutefois que dans ses livres, Taubes se montre un défenseur convaincu des régimes hyperprotéinés, donc il possède ses propres biais qu’il ne faut pas oublier quand on le lit (en se demandant s’il n’y a pas d’autres expériences qui iraient dans l’autre sens, par exemple), mais cela ne nuit pas à mon avis à son argumentation générale.

Causalité ou corrélation

Bien entendu, ces erreurs épistémologiques ne concernent pas que la santé et le poids. La confusion entre causalité et corrélation est fréquente à chaque fois qu’on étudie un phénomène qui ne se prête pas à l’expérience – autrement dit la plupart des sujets touchant à la sociologie. Les multiples études cherchant à montrer les dangers ou au contraire les bénéfices de nouveaux médias, de jeux vidéos, etc., sont particulièrement susceptibles de tomber dans ce travers. Et cela ne concerne pas que les amateurs. On pense aux propos de la baronne Susan Greenfield, l’une des plus célèbres psychologues britanniques, lorsqu’elle affirma : “Je remarque d’un côté la montée de l’autisme et de l’autre l’usage d’internet. C’est tout”.

Une affirmation si pseudoscientifique et péremptoire qui donna naissance à un tag twitter, #greenfieldism, qui a vu s’accumuler les affirmations les plus absurdes : “je remarque d’un côté le diabète et de l’autre les chats. C’est tout”. “Je remarque le réchauffement global et de l’autre le porno. C’est tout.” “Les allergies aux cacahuètes et les Kardashian ont connu simultanément une montée en puissance. Je suis sûr que ce ne peut être une coïncidence. “

Une formule populaire dit : on leur fait dire ce qu’on veut, aux chiffres. Ce n’est peut-être pas tout à fait vrai, mais les chiffres n’ont de signification que dans un contexte expérimental bien défini. En tout cas, il est encore loin le temps où les statistiques remplaceront la “bonne science”.

Rémi Sussan

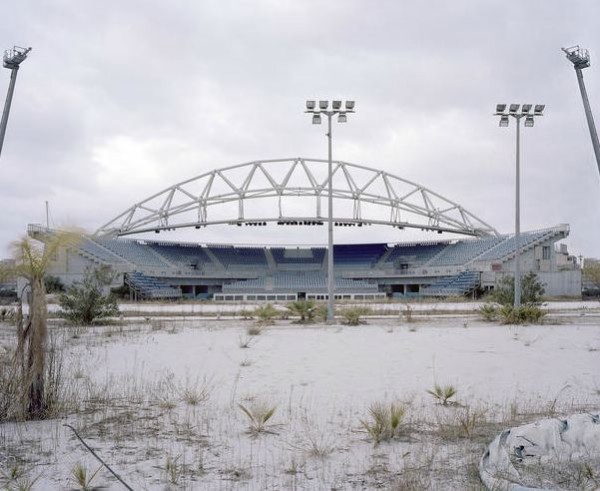

algorithmie, analyse des réseaux, économie comportementale, big data, complexité, humanités numériques, intelligence des données, NBIC, neuroscience, psychologie, quantifiedselfLes regards tournés vers les installations et dispositifs mis en place pour la ville de Londres, on en oublierait presque – pour ne pas dire complètement – le site alloué aux Jeux de 2004, à Athènes. Sur les 19 complexes sur 22 laissés à l’abandon, Jamie McGregor Smith profite de ce calme olympien pour nous faire un état des lieux de ces grands espaces, tranquilles et sinistres.

…………………………

Forcément, ces grands complexes abandonnés posent la question de la gestion des fonds alloués à la construction des locaux. Le besoin urgent et nationaliste de créer de vastes et coûteux complexes, le problème de ne pas savoir quoi en faire ensuite. Le photographe anglais Jamie McGregor Smith laisse cet aspect complètement à côté pour se concentrer sur le plaisir contemplatif de cette lente déprétitude. Un pêché mignon qui fonctionne toujours lorsque l’on se penche sur ce thème, souvenez vous.

L’intégralité de sa série Borrow, build abandon est à retrouver directement sur son site.

…………………………

+ Sur Lense, un monde laissé à l’abandon

+ via

Quel « business model » pour les opérateurs de télécommunications grand public ? Orange, Bouygues Télécom et SFR se veulent fournisseurs de services, voire de contenus, et donc ne veulent pas être de simples fournisseurs de tuyaux. La 4G, les « pure players » internet, les nouveaux usages, les réglementations de l’Arcep et autres remettent en cause cette vision. Ce billet est l’occasion de partager quelques réflexions autour de cette question : quel « business model » pour les opérateurs grand public ?

Prenons d’abord les précautions d’usage: il ne reflète que nos opinions personnelles et pas celles de notre employeur.

4G = tout IP

Les nouveaux réseaux 4G seront des réseaux full IP. Même la voix n’est plus qu’un service parmi d’autres, construits sur la stack IP, qui a décidément bien réussi à enterrer les protocoles de la téléphonie traditionnelle… Cela tend à simplifier l’architecture réseaux des opérateurs : plus de MSC par exemple. Quel est l’impact de ce changement de protocole ? Les opérateurs n’auront plus la maîtrise de certains services. Quelques exemples : iCloud qui remplace les SMS, Viber ou Skype qui remplace le téléphone.

L’opérateur mobile devient donc un opérateur IP. Or le business model des opérateurs IP (des entreprises inconnues du grand public), est différent des opérateurs grand public : il est entièrement orienté tuyau : pas ou très peu de services à valeur ajoutée, facturation à la bande passante ou au volume de donnée transporté… Les seuls services que vendent ces opérateurs sont des services « techniques » de communication : hosting, routage… Rien qui puisse intéresser le grand public ni faire la différence entre deux offres, si ce n’est la qualité du réseau en terme de couverture et de débit.

Les services

Nous sommes toujours surpris quand nous découvrons les interfaces web offertes par les opérateurs pour consulter sa messagerie @mon_opérateur.fr. Quel retard face à Gmail, Windows Live, ou Yahoo ! Ce genre de service n’est pas, et, pour nous, ne sera jamais le « core business » d’un opérateur. De plus, un opérateur ne pourra pas concurrencer les « pure players » sur ce terrain. Un exemple : une offre de vidéo à la demande. Certes la proximité du réseau va avantager l’opérateur en termes de performances. Mais en termes de fonctionnalité et de catalogue, un acteur spécialisé s’en sortira mieux qu’un opérateur, puisqu’il ne fait que ça. Par ailleurs, la réglementation de l’Arcep permet, en France, de changer facilement d’opérateur. Du coup, pourquoi choisir un service lié à un opérateur, plutôt qu’un autre, indépendant de l’opérateur, multi-device et donc accessible sur un téléphone Android, sur un iPad ou sur son ordinateur ? A ce titre, certains opérateurs ont des partenariats (deezer, canalplus) et proposent ces services dans leurs catalogues. Ce service n’est cependant pas lié à l’opérateur.

D’un autre côté, ayant le contrôle du réseau, les opérateurs sont capables d’offrir de meilleurs performances à certains fournisseurs de services ou de garantir des performances à leurs utilisateurs. L’utilisation de tels systèmes peut, dans certains cas, porter atteinte à la neutralité du réseau. Un exemple : Orange propose un abonnement Deezer. Depuis un portable Orange, la QoS (Quality Of Service) vers Deezer devrait donc être meilleure que vers Spotify ou autre (soit dit en passant, le problème se pose déjà sur l’ADSL, ou certains opérateurs limitaient le débit vers certains services : au hasard feu MegaUpload, ou à un certain moment, DailyMotion). Pour un opérateur télécom, fournir un service et assurer la neutralité du réseau est donc un exercice difficile, voire impossible : favoriser le service que l’on vend sans défavoriser les concurrents de ce service…

Y a-t-il des services qui seraient vraiment plus efficaces proposés par un opérateur, plutôt que par un tiers sur Internet ? Personnellement, pour un usage grand public, nous n’en voyons pas, du moins en full-IP comme sur la 4G. Même la TV devrait pouvoir passer normalement sur de la 4G, de la même façon que sur Internet. Et si les opérateurs proposent des services avec de meilleures performances, on revient au problème évoqué ci-dessus sur la neutralité du réseau. Les services sur lesquels les opérateurs devraient garder la main sont des services « bas niveau », très liés au réseau : géolocalisation, authentification, identification, paiement… Ces services sont des briques sur lesquels les fournisseurs de services de plus haut niveau pourront s’appuyer pour améliorer leur offre.

Relation client

Les opérateurs actuels gèrent la relation client. Ils peuvent utiliser cette position pour leur fournir des services à valeur ajoutée. Il est néanmoins probable que cet avantage se réduise. Apple et Google gèrent aussi des clients, via IOS et iTunes, Android et GoogleApps. Facebook et Twitter aussi. La part de ces acteurs « nouveaux » va s’amplifier, au détriment des opérateurs, car la valeur de leur marque est souvent plus puissante que celle des opérateurs pour attirer les clients à utiliser leur service. Un exemple, la messagerie visuelle de l’iPhone : c’est Apple qui a imposé aux opérateurs la façon de travailler. Un autre exemple : on assiste souvent à des débats sans fin iPhone versus Android. Rarement à des débats Orange versus SFR versus Bouyges Telecom. Ce choix-là ne se faisant généralement plus que sur le prix, ou la qualité du réseau.

Dans ce nouveau modèle économique que l’OCDE désigne comme modèle de la « connectivité sponsorisée », la relation entre le client et le fournisseur d’accès n’existe pas, la relation client étant portée par le prestataire de service. Cette transformation a déjà eu lieu pour Tomtom Live services ou Kindle Amazon, l’utilisateur n’a pas d’abonnement à un opérateur et ne sait pas quel est l’opérateur utilisé. L’opérateur télécom devient fournisseur d’infrastructure, et le fournisseur de service ou de terminal électronique (désigné comme « device subscriber ») package l’accès au réseau dans son produit. Il est intéressant de constater qu’en seulement 1 an, chez AT&T, le nombre d’abonnement lié aux « device subscribers » a plus que doublé en passant de 3,3 Millions à 7,8 millions soit environ 9% du total de leur souscriptions d’abonnement mobiles .

Conclusion

Que va-t-il se passer ? Le plus probable est que, hélas, nous assistions à la fin de la neutralité des réseaux. Pour compenser les coûts induits par la toujours plus grande consommation de bande passante, les opérateurs vont probablement vendre des services sans maintenir l’équité de entre fournisseurs. Le bras de fer entre les opérateurs et les défenseurs de la neutralité est en cours… Une neutralité maintenue et revendiquée pourrait alors devenir un argument commercial.

Un autre scénario est que les opérateurs recentrent leur business model autour du modèle fournisseur de tuyau, voir fournisseur de tuyau ++ (avec les services / API de bas niveau évoqué ci-dessus). Cela leur permettrait de réduire leur coûts en terme de complexité d’offre, de marketing, de développement de services, et de se recentrer sur leur « core business », le réseau. Egalement de se positionner les uns par rapport aux autres sur le plus important : la qualité de l’accès réseau.

Suggestion d'articles :

Les énergies renouvelables en détail dans notre dossier

Quelle proportion pourraient atteindre les sources d'énergies renouvelables dans la production d'électricité ? Les sources classiques, hydrocarbures et nucléaires, permettent assez bien...