Liste de partage de Grorico

Liste de partage de Grorico

L’Agence nationale pour la gestion des déchets radioactifs (Andra) a publié aujourd’hui son Inventaire national 2012 des matières et déchets radioactifs, dont il existe même une version “interactive”

A la lecture du dossier de presse, et au regard de l’interprétation qu’en ont fait certains médias (voir l’article du Figaro : La sortie du nucléaire coûtera très cher en déchets) il parait absolument essentiel de faire une rapide mise au point, ou en tout cas, d’aider l’Andra dans sa volonté “d’être une source d’informations précises pour le citoyen”

Vous avez dit déchets ?

Dans son dossier de presse, l’Andra propose une série de questions / réponses, qui aborde notamment cette question : “Quel impact l’arrêt du traitement des combustibles usés aurait-il sur les volumes de déchets et sur leur stockage ?“.

L’Andra répond à la question : “En cas d’arrêt du traitement, les combustibles usés seraient eux-mêmes considérés comme des déchets. Cela concerne tous les types de combustibles usés (dont le MOX par exemple) aujourd’hui entreposés dans l’attente d’une valorisation future. Les quantités de combustibles usés qui seraient à prendre en compte représenteraient un volume de colis de stockage de l’ordre de 90 000 m3.”

Oui mais …

Aujourd’hui seuls 4% des combustibles usés sont considérés comme des déchets et sont pris en compte dans l’inventaire de l’Andra. Ainsi, 96% des combustibles usés échappent à la définition de déchet et sont considérés comme des “matières valorisables”. La loi française prévoit en matière nucléaire qu’”un résidu issu d’un process de production pour lequel une utilisation future est envisagée n’est pas un déchet”.

La recherche sur une filière de 4ème génération (Astrid) supposée fonctionner avec du plutonium et de l’uranium appauvri (les 96% restants) dans un futur plus ou moins lointain (à noter que superphénix était déjà supposé fonctionner avec de tels matériaux) fait sortir ces 96% de la qualification de déchets nucléaires et donc de l’inventaire officiel de l’Andra. Oui, vous aurez noté la somme de conditionnel dans cette phrase….

Les 10 000 m3 annoncés par l’Andra sont donc en réalité les déchets vitrifiés (4% des combustibles usagés). Et si on compare ce chiffre au chiffre de déchets vitrifés dans un scénario de sortie du nucléaire il est de 3500 m3 … oui, c’est donc beaucoup moins.

Comment on arrive à 90 000m3 de déchets avec une sortie du nucléaire dans ces conditions, comme le suggère l’Andra dans ses “questions / réponses” ?

Tout simplement parce que l’Andra considère que la sortie du nucléaire serait couplée avec l’arrêt du retraitement qui ferait comme par magie augmenter le volume de déchets.

Remettons les choses dans leur contexte : aujourd’hui, seule une partie du plutonium (qui ne représente qu’1% du volume total des combustibles usagés) est utilisée pour fabriquer du MOX, qui lui, n’est pas recyclable. Le HCTISN a publié un rapport en 2010 qui affirmait que le retraitement ne permettait pas d’économiser de ce fait plus de 12% d’uranium frais. De leur côté les ONG annonce moins de 2,5%…

C’est en réalité l’abandon de la 4ème génération (Astrid, petite fille de Superphénix), ou la démonstration de l’incapacité technique à faire fonctionner un réacteur en surgénération qui amènerait à une nécessaire requalification juridique du déchet nucléaire et donc à une hausse du volume de ces déchets.

Donc ces déchets existent bel et bien aujourd’hui, ils ne sont pas recyclés puisque moins de 1% est utilisé pour faire du MOX et une seule centrale utilise de l’URE (uranium de retraitement appauvri réenrichit en Russie), celle de Cruas-Meysse …

La différence de chiffres de 90 000 m3 à 10 000 m3 réside donc dans le fait que ces déchets qui sont aujourd’hui appelés “matières valorisables” et sont entreposés sur les sites d’Areva (principalement La Hague) en attendant qu’un jour, peut être, ils soient potentiellement utilisés, rentreraient alors dans l’inventaire officiel de l’Andra.

Le risque principal ne réside donc pas dans la sortie du nucléaire !

Mais dans les défaillances techniques de la 4ème génération, qui aboutiront à une requalification de la notion de déchets et qui posera surtout la question des coûts financiers de leur gestion.

La lecture de la semaine, il s’agit d’un article du New York Times, sous la plume de John Markoff (@markoff), il s’intitule : “Combien faut-il d’ordinateurs pour identifier un chat ?”

“A l’intérieur du très secret Laboratoire X de Google, commence Markoff, laboratoire connu pour inventer des voitures automatiques et des lunettes à vision augmentée, un petit groupe de chercheurs a commencé il y a plusieurs années déjà à travailler sur la simulation du cerveau humain. Ils ont créé une machine apprenante, composée du plus grand circuit neuronal existant, 16 000 processeurs d’ordinateur connectés les uns aux autres, une machine qu’ils laissent se perdre sur Internet afin qu’elle apprenne par elle-même. En contact avec 10 millions d’images numériques trouvées sur les vidéos de Youtube, qu’a fait le cerveau de Google ? Ce que font des millions d’êtres humains sur Youtube : il a cherché des chats.

Le réseau neuronal a appris par lui-même à reconnaitre les chats, ce qui n’est pas une activité frivole. Si les chercheurs n’ont pas découvert à cette occasion que l’internet était rempli de chats, la simulation les a surpris. Elle a beaucoup mieux fonctionné que toutes celles qui l’ont précédée, en doublant à peu près sa précision dans la reconnaissance d’objets. Ce travail est représentatif d’une nouvelle génération de la science informatique qui exploite la chute des coûts du matériel et la disponibilité de gigantesques centres de données. Et cela permet des avancées significatives dans des champs aussi différents que la vision par ordinateur, la reconnaissance vocale et la traduction. Bien que certaines des idées de la science informatique ne soient pas neuves, la simple échelle des simulations logicielles mène à des systèmes apprenants qui étaient inimaginables auparavant. Et les chercheurs de Google ne sont pas seuls à exploiter ces techniques qu’on appelle des modèles de deep learning, “apprentissage profond”. L’an dernier, des chercheurs de Microsoft ont présenté une étude montrant que ces techniques pouvaient s’appliquer aussi bien à la construction de systèmes informatiques qui peuvent comprendre le langage humain.

Et puis, bien sûr, il y a les chats. Pour les trouver, l’équipe de recherche a utilisé un assemblage de 16 000 processeurs pour créer un réseau neuronal avec plus d’un milliard de connexions. Ils les ont ensuite alimentés au hasard de vignettes extraites de 10 000 millions de vidéos Youtube. Ce qui rend ce travail particulièrement saisissant, c’est que le réseau neuronal à base logicielle créé par les chercheurs est assez proche des théories des neurones miroirs développés par les biologistes, théories selon lesquelles les neurones individuels sont entraînés dans le cerveau à détecter des objets signifiants. La plupart des technologies de vision par ordinateur existantes supposent des êtres humains qui supervisent le processus d’apprentissage en labellisant les traits distinctifs. Dans la recherche de Google, les machines le font sans aucune aide. Un des scientifiques explique : “L’idée est qu’au lieu d’avoir des équipes de chercheurs qui essaient de trouver comment identifier des contours, vous envoyez une tonne de données à l’algorithme, vous laissez parler les données et le logiciel apprend automatiquement des données.” Un autre ajoute : “Pendant l’entraînement, nous n’avons jamais dit à a machine « Ceci est un chat » elle a fondamentalement inventé le concept de chat.” Ce qui en fait, selon les scientifiques qui ont mené l’expérience, une sorte de cousin cybernétique de ce qui tient lieu de cortex visuel dans le cerveau.

Mais, il y a une différence, note un des chercheurs : malgré l’immense capacité informatique utilisée, ça n’est rien comparé au nombre de connexions ayant lieu dans le cerveau. “Notre réseau est encore petit comparé au cortex visuel de l’homme, qui est un million de fois plus gros en termes de nombre de neurones et de synapses”, indique le compte-rendu de l’étude. Malgré cette différence, l’étude de Google apporte une nouvelle preuve que les algorithmes des machines apprenante qui existent aujourd’hui s’améliorent nettement quand on fournit à ces machines un grand nombre de données. L’expérience menée sous l’égide de Google est une avancée manifeste, à tel point qu’un chercheur en Informatique de Georgia Tech prédit que l’aptitude à modéliser un cortex visuel humain dans sa totalité pourrait être atteinte d’ici dix ans. Malgré ce succès, les chercheurs de Google demeurent prudents sur le fait qu’ils aient atteint le Saint Graal de machines qui peuvent apprendre par elles-mêmes. La conclusion du chercheur qui a mené l’expérience : “Ce serait fantastique qu’il suffise d’utiliser des algorithmes connus et de les faire tourner avec plus de données, mais mon sentiment profond est que n’avons pas encore le bon algorithme.”

Xavier de la Porte

analyse des réseaux, big data, complexité, intelligence artificielle, intelligence des données, neurosciences, pdlt, programmation, science, vie artificielleXavier de la Porte (@xporte), producteur de l’émission Place de la Toile sur France Culture, réalise chaque semaine une intéressante lecture d’un article de l’actualité dans le cadre de son émission.

L’émission du 7 juillet était consacrée aux Monnaies à l’heure du numérique, en compagnie de Jean-Michel Cornu (@jmichelcornu), auteur De l’innovation monétaire aux monnaies de l’innovation (voir notre dossier) et animateur du groupe de travail de la Fing dédié à ces questions.

Il n’y aura pas d’émission le 14 juillet(contrairement à ce qui était prévu initialement, il y a eut une émission le 14 juillet) et vous retrouverez Xavier de la Porte pour une dernière émission de l’année (sans lecture) le 21 juillet qui accueillera Clive Thompson (@pomeranian99), le célèbre éditorialiste du magazine américain Wired. Toute l’équipe de Place de la Toile vous souhaite de bonnes vacances et vous retrouvera à la rentrée !

L'égalité des sexes, ce n'est pas encore pour aujourd'hui. Malgré les luttes féministes et les mouvements de libération de la femme entamés depuis une cinquantaine...

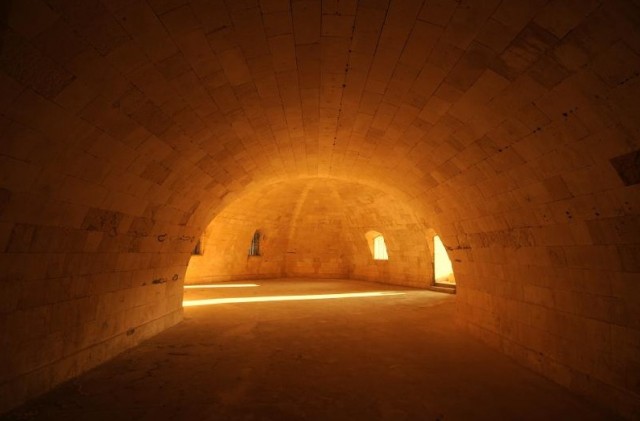

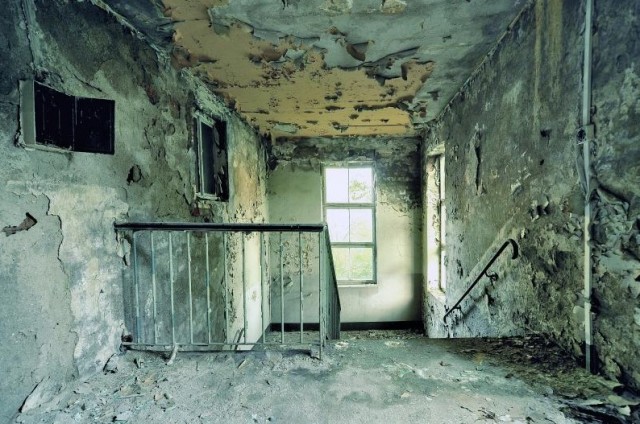

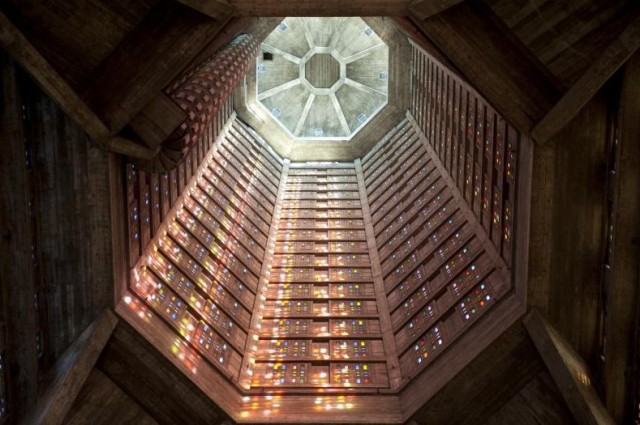

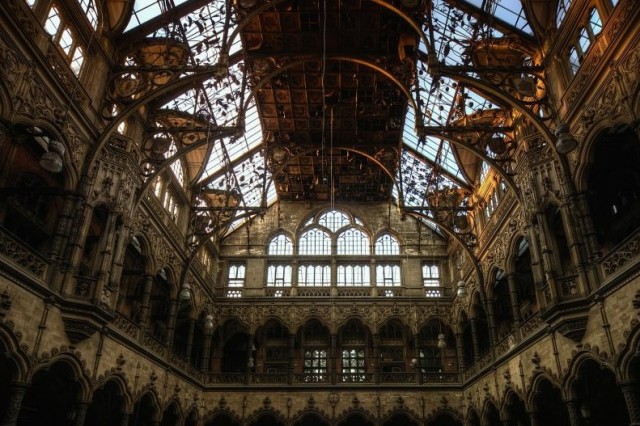

Focus sur le travail du photographe français Aurélien Villette, qui propose des clichés magnifiques d’exploration autour de l’architecture oubliée sous le nom de l’artiste Adonis. Visuellement impressionnantes, les photographies de ce dernier provenant de plusieurs séries se dévoilent dans la suite de l’article.

Un récent article de la Technology Review fait le point sur les recherches actuelles en biologie synthétique et pointe surtout vers des directions prometteuses.

La biologie synthétique est un sujet fascinant mais dont la valeur scientifique est souvent controversée. Grosso modo, cette discipline récente propose de créer ex nihilo des séquences complètes d’ADN et donc, à terme, des créatures originales. L’objectif n’est pas de fabriquer des minotaures ou des sirènes mais surtout de nouvelles bactéries. Le but avoué de bon nombre de chercheurs serait la mise au point d’organismes susceptibles de produire des biocarburants en grande quantité et, on l’espère, moins polluants qu’actuellement.

Au centre de la biosynthèse figure l’idée de code et la métaphore informatique : on peut agir sur l’ADN comme on le ferait sur un programme. En isolant certaines fonctions au sein de la double hélice, on pourrait même générer des “composants de base” d’une toute nouvelle architecture logique. On serait ainsi en mesure de créer des langages de programmation de la vie de “haut niveau”, qui permettraient aux ingénieurs du futur de bidouiller l’ADN sans entrer dans les complications chimiques.

Toutefois, c’est justement cette métaphore informatique qui pose problème. De nombreux biologistes traditionnels froncent les sourcils à cette idée. A leurs yeux, le vivant, système complexe par excellence, ne saurait être contrôlé par des méthodes issues de logiques aussi simples. Pas question non plus, selon eux, d’évacuer la réalité des interactions chimiques au profit d’abstractions purement formelles.

Mais même les pionniers de la biologie synthétique sont conscients des limites d’une approche trop simpliste et réductionniste.

Ainsi, James Collins (Wikipedia). Celui-ci est le premier à avoir créé au début des années 2000 un “interrupteur vivant”, autrement dit un couplage de deux séquences d’ADN qui s’inhibaient l’une l’autre, ce qui faisait que lorsqu’une des séquences produisait une protéine, elle empêchait l’autre de s’exprimer – et vice versa. Ce système a donné naissance à une multitude de composants vivants plus sophistiqués et au système des biobricks, l’un des projets phares de la biologie synthétique contemporaine.

Pourtant Collins lui-même n’est pas enthousiaste du tour qu’ont pris aujourd’hui les choses : trop tôt, trop vite selon lui.

On s’est précipité pour créer un marché autour d’une technologie qui n’était pas prête, a-t-il expliqué à la Technology Review. “Les entreprises sont en train de siphonner tout l’oxygène de la discipline… Elles absorbent toutes nos semences, c’est à dire les jeunes chercheurs qui devraient rester dans les laboratoires universitaires et travailler à de nouvelles manières de faire du génie génétique”. Et Collins de prédire qu’“un grand nombre de carcasses d’entreprises de biotechnologie joncheront le côté de la route dans les prochaines années”.

Une image d'Existenz, le film de Cronenberg, hanté par la présence des mutations biologiques

Un “retour à la nature”, via la génomique

Parmi ces “cadavres”, on trouve la première société de George Church, Codon Devices (censée devenir, selon Church, le “Intel de la biotechnologie”), laquelle a dû fermer ses portes en 2004. George Church, on le connait bien et Internet Actu lui a consacré bon nombre de pages. De fait, l’article de la Technology Review tourne autour de la nouvelle start-up de Church, Warp Drive Bio. Celle-ci connaîtra peut-être un sort plus enviable que Codon Devices, ayant attiré l’attention de Sanofi Aventis, et conclu un fructueux partenariat avec cette entreprise française.

Mais l’intérêt est ailleurs. La Technology Review a interrogé le cofondateur de Warp Drive Bio, Gregory Verdine. Ce dernier adopte une nouvelle approche de la biologie de synthèse qui, pour employer l’expression de Church, s’avère “ironique et intéressante”. Plutôt qu’utiliser les outils de la “synbio” afin de créer des organismes à partir de rien, pourquoi ne pas partir dans le sens inverse en essayant de comprendre comment la nature a mis au point des composés tout à fait efficaces ?

En effet, explique Verdine, depuis des années les compagnies pharmaceutiques ont accumulé des millions d’échantillons issus de divers environnements. Leur but était d’y repérer des composés susceptibles de posséder des vertus thérapeutiques. Mais continue-t-il, la quête était longue, et surtout guidée par la chance. Du coup, cette forme de recherche a été largement délaissée.

Selon Verdine, on peut maintenant aller beaucoup plus vite. Au lieu de faire de longues analyses chimiques d’un échantillon, on peut directement chercher l’ADN. “Grâce à la baisse des prix des outils de séquençage, on peut tester l’ADN de tous les microorganismes se trouvant, par exemple, dans une goutte de vase.”

En effet, continue Verdine, la plupart des produits médicinaux rencontrés dans la nature mettent en jeu des groupes de gènes assez similaires. On pourrait donc scanner les échantillons en quête de tels groupes, pour voir s’il est possible de découvrir de nouveaux composés. Restera ensuite à synthétiser ces molécules en utilisant les techniques de l’ingénierie génétique.

“Nous utilisons la génomique et la bioinformatique pour découvrir un groupe de gènes. Mais ce dernier est juste une unité d’information. Ce qui nous intéresse c’est d’obtenir la molécule. La biologie synthétique a pour but d’incorporer ce groupe de gènes dans des usines biosynthétiques, susceptibles de créer la molécule. Si vous n’obtenez pas la molécule, les gènes sont inutiles”.

Que ce soient les méthodes de Verdine, la “machine à accélérer l’évolution” de Church ou l’application des théories de la vie artificielle à la biologie synthétique (comme dans les travaux de Ricard Solé), il semble donc qu’on assiste aujourd’hui à une convergence entre la biologie traditionnelle, respectueuse des systèmes complexes et la méthode plus “informatique” de la biologie synthétique.

Rémi Sussan

biotechnologies, NBIC

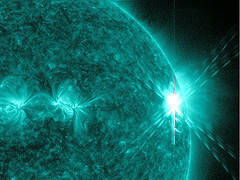

Début mars dernier, on a eu droit de la part du Soleil à quelques éruptions solaires d’une rare intensité. Les médias qui ont alors rapporté le phénomène ont parlé de risques de pannes des appareils électroniques, mais sans vraiment dire pourquoi (ça aurait pu risquer d’être intéressant, sûrement).

Il y a deux genres d’effets que ces éruptions solaires peuvent avoir sur l’électronique : une à très petite échelle (échelle atomique), une autre à très grande échelle (échelle d’un continent ou d’un pays).

Les éruptions solaires sont dues à la brisure de lignes de champs magnétiques dans la photosphère solaire. Le long de ces lignes de champs circulent des particules chargées (protons, électrons, ions…). Les cassures de ces lignes se font un peu comme lorsque l’on tord une poignée de spaghettis crus : plein de petits morceaux sont éjectés. Pour le Soleil, il s’agit de l’éjection d’une énorme quantité de particules à haute énergie.

Lorsque ce nuage de particule arrive au niveau de la Terre à très grande vitesse, il est normalement dévié par le bouclier magnétique terrestre. Certains protons arrivent cependant à s’infiltrer entre les lignes de champs magnétique terrestre et réagissent avec les particules de l’atmosphère qui émettent alors un peu de lumière : ce sont les aurores polaires. Si ce sont d’autres particules non-chargées mais très énergétiques, elles peuvent arriver jusqu’à la surface et interagir avec la matière solide, dont les ordinateurs par exemple. C’est là qu’elles peuvent causer des dégâts, comme par exemple changer l’état logique de quelques bits dans la mémoire, provoquant des pannes et des bogues. C’est un effet à petite échelle : seuls quelques bits sont modifiés.

Notez que ces effets n’ont pas forcément pour cause une éruption solaire. Les particules à haute énergie peuvent venir d’ailleurs dans l’univers.

L’effet à grande échelle est provoqué par le nuage de particules chargées arrivant sur le bouclier magnétique terrestre : le bouclier se déforme et il oscille, comme poussé par le nuage. De ce fait, le champ magnétique perçu à la surface de la Terre varie le temps que le nuage de particules nous balaye.

La surface de la Terre est recouverte de fils électriques installés par l’homme, que ce soit dans la maison, mais aussi des centaines de kilomètres de lignes électriques traversant des pays entiers.

Or, un champ magnétique variable induit dans les conducteurs autour un courant électrique. Donc il y a dans les fils électriques des surtensions ou des sous-tensions dues à l’oscillation du champ magnétique terrestre (jusqu’à 15% de variation). Les conséquences peuvent être des pannes de courant dans des villes ou des régions entières. C’est ce qui s’est passé par exemple au Canada et aux États-Unis en 1989, où une éruption solaire importante a coupé le Québec et une partie du nord-est des États-Unis d’électricité pendant plusieurs heures.

ÉDIT : oh, voilà une image de XKCD que j’avais oublié de mettre, et qui parodie ce phénomène d’induction de courant à cause de l’oscillation du champ magnétique terrestre : xkcd.com/509.

Le groupe Areva a indiqué vendredi dernier avoir remporté l'appel d'offre lancé par la ville de La Croix Valmer (département du Var) pour la fourniture d'un système de stockage d'énergie.

Le groupe Areva a indiqué vendredi dernier avoir remporté l'appel d'offre lancé par la ville de La Croix Valmer (département du Var) pour la fourniture d'un système de stockage d'énergie.

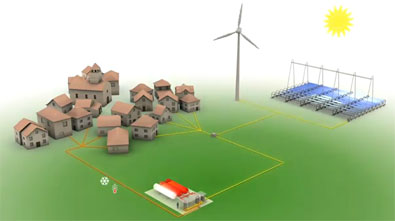

La Croix Valmer, commune du Golfe de St Tropez, initie un projet innovant - le projet Janus - qui consiste à développer et mutualiser un ensemble de systèmes de production d’énergies intitulés « chaine hydrogène » basés sur l’utilisation des techniques photovoltaiques, de l’hydrogène et de son stockage pour mettre en oeuvre des piles à combustible hydrogène / oxygène.

L’objectif est de contribuer à l’autonomie énergétique partielle, de secourir des bâtiments de la commune et de contribuer à la stabilité du réseau électrique général (EDF).

Areva installera une Greenergy Box, procédé industriel innovant de stockage d'énergie développé avec le support de l'organisme public de financement et de soutien à l'innovation technologique OSEO, dans le cadre du programme Horizon Hydrogène Energie (H2E).

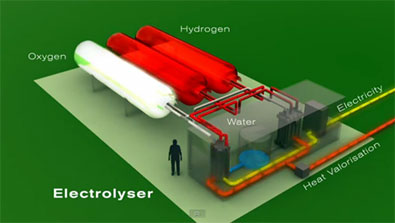

La Greenergy Box d'Areva, qui se compose d'un électrolyseur et d'une pile à combustible, est un dispositif unique au monde. Il permet le stockage d'hydrogène et d'oxygène obtenus par électrolyse de l'eau en période de faible demande d'énergie et leur recombinaison pour produire de l'électricité lors des pics de consommation.

A l'instar des installations de la plateforme MYRTE déployée en Corse par Areva depuis janvier 2012, la Greenergy Box de La Croix Valmer sera connectée à des panneaux photovoltaïques de 35 kW crête situés sur un bâtiment public. Elle servira à compenser une baisse de production ou prendre le relais du réseau électrique de la commune en cas de coupure.

Son installation interviendra au cours du dernier trimestre 2013. La région PACA, l'ADEME et le FEDER figurent parmi les partenaires de financement de cette opération. Ce projet bénéficiera du retour d'expérience de la plateforme MYRTE dont les résultats ont démontré l'efficacité des solutions hydrogène en environnement réel.

Pour Luc Oursel, Président du Directoire d'Areva, « le stockage d'énergie représente un atout majeur pour le développement des énergies renouvelables dans le monde. L'installation de cette deuxième Greenergy Box confirme le passage de notre technologie de la phase de recherche à la phase industrielle. Avec ce succès commercial, Areva se positionne plus que jamais parmi les leaders de la filière hydrogène et pile à combustible. »

François Gimmig, maire de La Croix Valmer, a déclaré : « L'avancée de ce projet nous conforte dans nos choix et confirme notre position de commune innovante et leader en matière de développement durable. Le soleil de La Croix Valmer attire depuis longtemps de nombreux visiteurs ; désormais sa valeur prendra une autre dimension économique, ainsi qu'une valeur sociale et environnementale. »

Le contexte énergétique de La Croix Valmer

La Croix Valmer, commune du Golfe de Saint Tropez, est soumise à de fortes variations de fréquentation entre la période hivernale et la période estivale, où la population est multipliée par 10. En outre, située géographiquement en bout de réseau électrique, La Croix Valmer est sujette à des coupures de courant intempestives et répétées et est, par ailleurs, confrontée à une facture d'électricité importante.

Dans ce contexte énergétique sensible, la commune s'est fixée l'objectif ambitieux d'être la plus autonome possible dans sa consommation énergétique, de limiter ainsi sa dépendance au réseau, de préserver l'environnement et d'agir dans une logique de développement durable. La Croix Valmer a mis en place un Agenda 21, en cours de labellisation, et a lancé le projet Janus, labellisé le 5 octobre 2010 par Capénergie.

Un concept innovant

Ce projet consiste à développer et mutualiser un ensemble de systèmes d'énergie reposant sur des choix techniques de couplage de panneaux solaires photovoltaïques / chaîne hydrogène, basée sur la solution Greenergy Box de HELION - AREVA pour le stockage de l'énergie à base d'hydrogène.

Cette solution consiste à intégrer le modèle suivant :

- faire l'électrolyse de l'eau pour produire de l'hydrogène et de l'oxygène

![]() stocker ces deux gaz pour obtenir l'autonomie suffisante

stocker ces deux gaz pour obtenir l'autonomie suffisante

![]() mettre en oeuvre une pile à combustible pour produire de l'électricité et de l'énergie thermique (eau chaude 70°)

mettre en oeuvre une pile à combustible pour produire de l'électricité et de l'énergie thermique (eau chaude 70°)

L'idée maîtresse autour du modèle énergétique, est de développer notre capacité de constituer, de disposer et de gérer un stock énergétique conforme aux nouvelles orientations et de permettre à nos enfants de ne plus dépendre des énergies fossiles qui, c'est certain, sont destinées à disparaître.

Le caractère innovant du projet Janus repose principalement sur :

- la mise en œuvre programmable et contrôlable des chaînes hydrogène,

![]() la production décentralisée des gaz permettant de s'affranchir d'une logistique d'approvisionnement,

la production décentralisée des gaz permettant de s'affranchir d'une logistique d'approvisionnement,

![]() la gestion intelligente de la mutualisation de différentes sources de production énergétiques (solaire, hydrogène, réseau),

la gestion intelligente de la mutualisation de différentes sources de production énergétiques (solaire, hydrogène, réseau),

![]() l'îlotage des bâtiments : continuation de l'alimentation des bâtiments lors de la perte du réseau électrique

l'îlotage des bâtiments : continuation de l'alimentation des bâtiments lors de la perte du réseau électrique

La finalité du projet

Les principaux objectifs ciblés par la commune de La Croix Valmer au travers de Janus sont :

![]() d'assurer une production « verte » d'énergie électrique et thermique des bâtiments municipaux,

d'assurer une production « verte » d'énergie électrique et thermique des bâtiments municipaux,

![]() de rendre ces bâtiments partiellement autonomes en énergie et secourus en cas de perte de réseau,

de rendre ces bâtiments partiellement autonomes en énergie et secourus en cas de perte de réseau,

![]() de réduire la facture énergétique de la commune dans une logique de développement durable,

de réduire la facture énergétique de la commune dans une logique de développement durable,

![]() de développer une solution fiable et sûre, transmissible aux générations futures

de développer une solution fiable et sûre, transmissible aux générations futures

![]() de faire de la commune une vitrine environnementale sur les plans communal, régional et national, voire sur la scène européenne.

de faire de la commune une vitrine environnementale sur les plans communal, régional et national, voire sur la scène européenne.

Janus est un projet novateur qui s'inscrit également dans une démarche d'amélioration continue des performances visant non seulement la baisse des coûts des équipements mais aussi l'augmentation d'autonomie énergétique des bâtiments.

On se demande bien pourquoi cela n’avait pas encore été fait… Youtube, premier fournisseur de vidéos au monde, se prépare à lancer des chaines de télé en France ! Ne cherchez pas sur la TNT ou même sur le câble, comme c’était prévisible, le tout se fera en ligne directement...

Article publié sur le Blog du Modérateur : Youtube va lancer 13 chaînes de télé en France Suivez également l'actualité du blog sur Twitter et Facebook